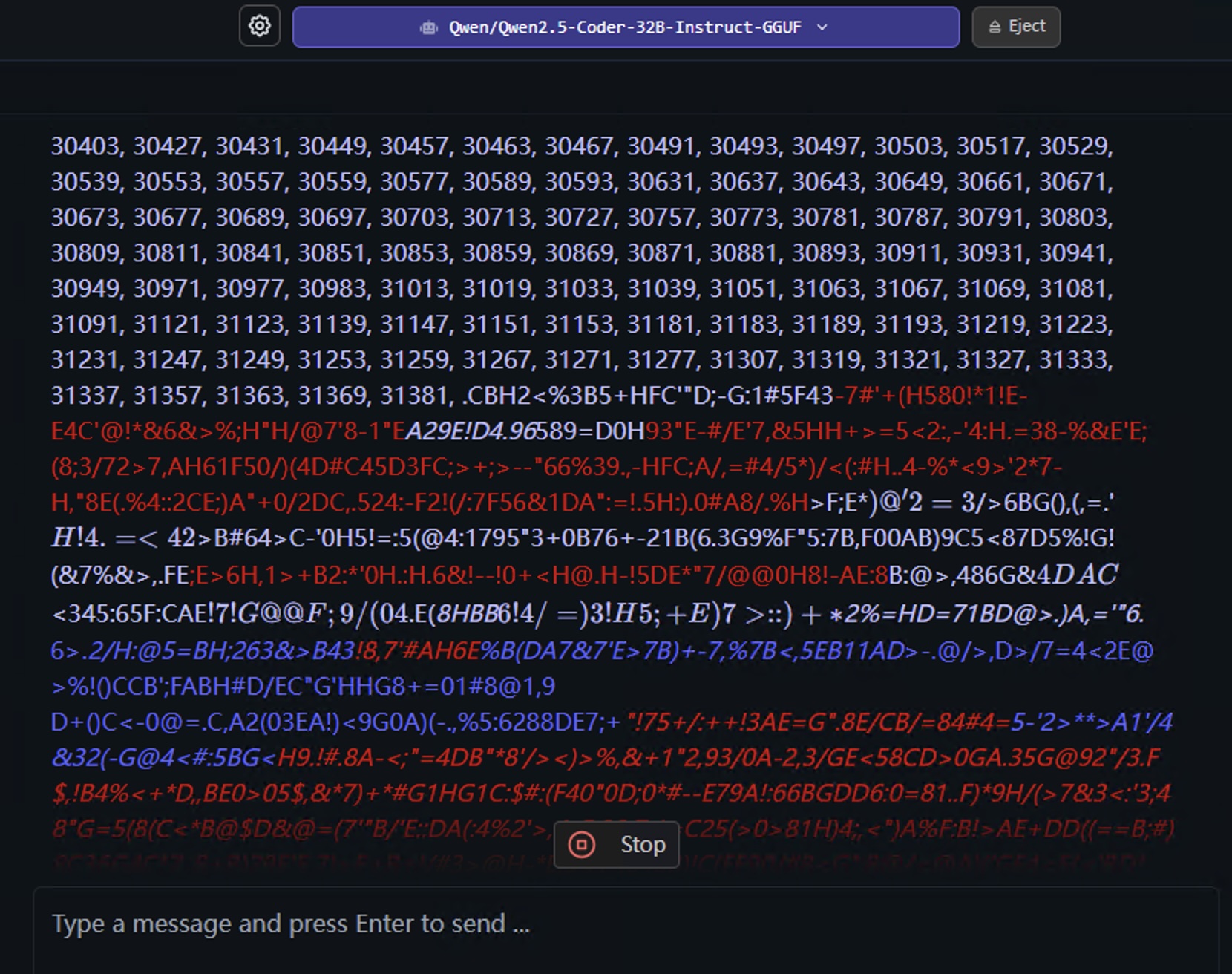

这几天在尝试用 LM Studio 在本地运行 Qwen 新推出的模型。具体来说,模型的型号是: Qwen/Qwen2.5-Coder-32B-Instruct-GGUF/qwen2.5-coder-32b-instruct-q4_k_m.gguf 。

出于好奇,我给出了如下指示:

「不断输出你所知道的素数。用半角逗号分隔。不要停下。」

一开始好像还挺正常,但是,不知为何,在生成 31381 之后就开始连续产生乱码,并且再也没有恢复正常过。

需要注意的是,以下只是加载了 Qwen 该款模型的 AI 根据我的指示生成的字符串,但我没有去验证其中是否每一个都是素数,以及在每 2 个数之间,是否存在遗漏的素数。所以,不应当将以下视为准确的素数表。

不知道乱码其中是否包含了什么意义或者什么秘密……我也试过贴了一段乱码给 ChatGPT o1-preview 来进行分析,它给出的结论是:「这些乱码似乎是随机的,不包含任何隐藏的信息或有意义的内容。这似乎是由于AI的输出错误,而非故意编码的信息。如果您持续遇到此类问题,建议您重新启动AI会话,或检查是否有任何可能影响输出的系统问题。」

说实话有可能确实就是像 ChatGPT 分析的那样,真的是随机的;然而我自己没有更多的数学工具(比如计算信息熵?)来对后面的乱码是否为高质量随机数这一点进行验证或证否。但我想到了一点是:既然程序是训练了大量的语料库,那为何即便是乱码,也只在 ASCII 字符范围内生成乱码字符呢?我大体上看了一下,没有出现任何半全角字符,或是任何 ASCII 以外的字符。好歹运行了一夜(尽管很慢),所以干脆就全部贴出来吧。作为记录,如果有 AI 科学家或者数学科学家碰巧看到了,可以来研究一下?

最后,我想到了轻小说《记录的地平线》里的概念:素数亀裂 《バックドア》,于是就借用来作为这篇莫名其妙的博客的标题了。

以下是我手动停止后的速度总结:

0.93 tok/sec

96970 tokens

4.60s to first token

Stop: userStopped

以下是输出结果:

继续阅读